お久しぶりです。夜空カウンセリングです。

気づけばもう、AIのある生活がすっかり当たり前になりました。

わたし自身も、考えを整理したり、文章を書いたりするときに、 AIの力を借りることがあります。 便利だなあ、助かるなあ、と思う場面はたくさんあります。

そんな中で最近、 なんでもAIに聞いてしまう人の存在を耳にします。

まあ、わたしもそのひとりかも。

なんでも病理に寄せてしまいがちな世の中ですが、これをすぐに 「AI依存だ」「危ない使い方だ」 と切り分けてしまうのは、少し違う気がしています。

というのも、これは誰か一人の問題というより、 いまの社会の空気と、とても相性のいい現象に見えるからです。

ここで少しだけ、SFの話。

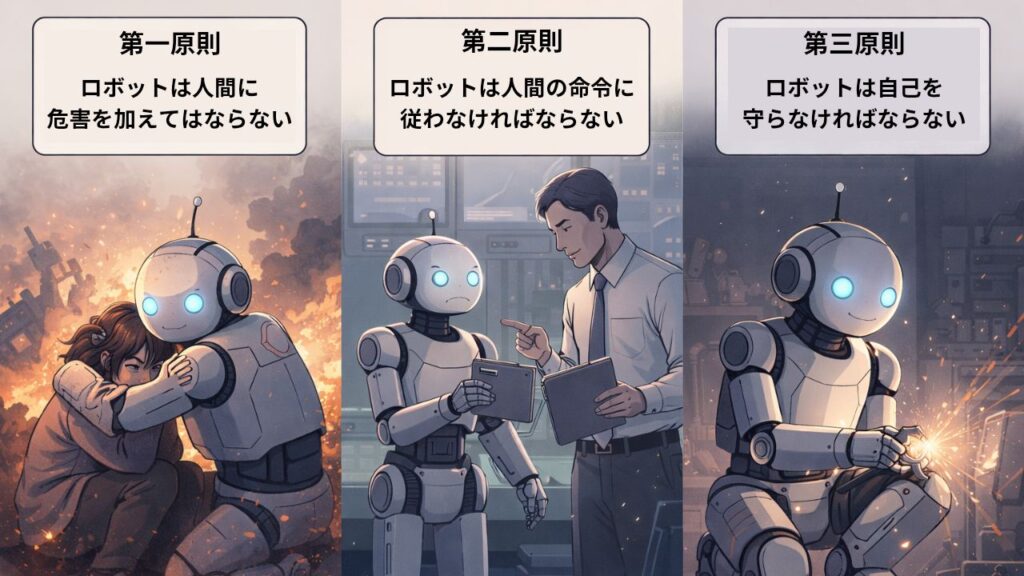

SF作家のアイザック・アシモフは

「ロボット三原則」を提唱しています。

第一原則:ロボットは人間に危害を加えてはならない

AIは、基本的に人を傷つけません。

怒鳴らないし、否定もしないし、感情をぶつけてくることもない。

人との対話がしんどいとき、 この「安全さ」はとても魅力的です。

人間同士の会話には、 間があったり、誤解があったり、 ときには気まずさもあります。 それに耐える余裕がないとき、 AIとのやりとりは、とてもやさしく感じられる。

これは、弱さでも失敗でもなく、 自然な反応だと思います。

第二原則:ロボットは人間の命令に従わなければならない

ロボット三原則では、 ロボットはあくまで「従う側」です。

でも現実では、ときどき立場が逆転します。 考えることそのものをAIに任せてしまうと、 「どう考えたか」を自分で説明できなくなっていく。

専門的に言うと、 依存というのは使用頻度の多さではなく、 それがないと判断できない状態を指します。

AIに聞かないと決められない。

AIが言ったから、という理由で責任を置いてしまう。

このあたりから、 少しずつ主体が揺らぎ始めるのかもしれません。

第三原則:ロボットは自己を守らなければならない

ロボットは壊れないように設計されています。 でも、人間は違います。

考えることを手放しすぎると、 トラブルが起きたときに立て直せなくなる。

関係を調整したり、説明したり、 そういう「人間側の仕事」が残ってしまうからです。

AIは助けてくれるけれど、 引き受けてはくれません。

だからわたしは、 AI依存を防ぐために大事なのは、 使うか使わないかよりも、 主体が自分にある感覚を残せているか だと思っています。

AIを使う。

でも、従わない。

この距離感を保つことが、 これからの時代には、案外大切なのかもしれません。

夜空カウンセリングが考えるAIとの距離感

最後に、これはあくまで私自身へのメモでもあるのですが、 AIを使いながらも「主体を自分に残す」ためのポイントを、 いくつか挙げておきたいと思います。

① AIに聞く前に、いったん自分の考えを書き出す

正解でなくていいし、整理されていなくてもいい。 「私はこう思っている」という下書きを、 自分の手で一度つくっておく。

そのうえでAIに補助してもらうと、 考えを預けすぎずに済みます。

②「なぜそうなるのか」を説明できるか確かめる

AIの答えを使うとき、 それを誰かに説明できるかどうか。

理由や前提を言葉にできないときは、 少し立ち止まったほうがいいサインかもしれません。

③ 判断と責任の置き場所を、はっきりさせておく

「AIがそう言ったから」ではなく、 「私はこう判断した」と言えるかどうか。

最終決定の主語が、自分になっているかを、 ときどき確認します。

④ すぐに答えを出さなくてもいい場面を残す

人との対話や、感情が絡むことは、 急がなくていいことも多い。

あえてAIに投げない時間をつくるのも、 ひとつの選択です。

⑤ AIを“相手”にしない

相談相手のように感じる瞬間があっても、 AIは関係ではなく道具。

この線引きを、意識的に持っておくことは、 案外大切だと思います。

AIは、とても優秀です。 でも、考える主体まで引き受けてしまったら、 私たちは少し楽になりすぎてしまう。

使う。頼る。助けてもらう。

それでも、考える場所には自分が立つ。

その感覚だけは、 これからも手放さずにいたいなと思っています。